‘반도체의 봄’ 성큼

![SK하이닉스 직원들이 반도체 공정을 확인하고 있는 모습. [사진 SK하이닉스]](https://pds.joongang.co.kr/news/component/joongang_sunday/202402/03/c48ec1d4-27f7-4ec2-bccc-c92d2d2109f1.jpg)

SK하이닉스 직원들이 반도체 공정을 확인하고 있는 모습. [사진 SK하이닉스]

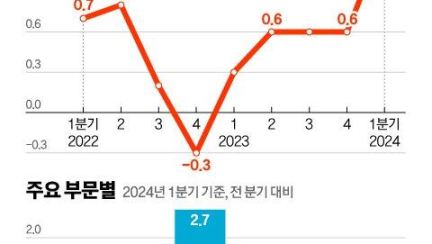

지난해 4분기 SK하이닉스는 3460억원의 영업이익을 기록했다. 증권가 예상치의 5배에 달하는 ‘어닝 서프라이즈’이자 5분기 만에 흑자 전환이다. SK하이닉스는 2022년 4분기 1조9122억원의 영업손실을 내는 등 이때부터 4개 분기 동안 누적된 적자 규모만 약 10조원에 달한다. 지난해 4분기 매출도 11조3055억원으로 전년 동기 대비 47.4% 증가했다. SK하이닉스 측은 “인공지능(AI) 서버와 모바일용 반도체 수요가 늘어 평균판매단가(ASP)가 오르는 등 시장 환경 개선에 힘입었다”며 “특히 지난해 4세대 고대역폭메모리(HBM)인 HBM3 매출이 전년 대비 5배 이상 증가했다”고 설명했다.

삼성전자는 지난해 4분기 매출(67조7800억원)과 영업이익(2조8200억원)이 전년 동기 대비 각각 3.8%, 34.4% 감소했다. 하지만 전 분기보다는 영업이익이 16.1% 증가하는 등 반도체 사업의 반등이 뚜렷했다. HBM 등 고부가가치 제품 판매 확대로 4분기 D램 흑자 전환에 성공했다고 삼성전자 측은 밝혔다.

AI 시대의 ‘게임 체인저’로 떠오른 HBM이 한국 반도체 수출의 선봉장 역할을 하고 있다. HBM은 한국 반도체 수출의 주력품인 메모리 반도체 D램 여러 개를 수직으로 연결한 고성능 메모리다. 면적당 훨씬 높은 용량을 확보할 수 있어 대(大)용량의 데이터 처리가 가능하고 처리 속도도 크게 빨라진다. 즉, 방대한 양의 데이터를 실시간으로 빠르게 처리하고 사용하는 것이 필수인 고성능 컴퓨팅(HPC) 기술에 특화된 초고속 메모리다. HPC는 ‘챗GPT’ 등 AI 기술 고도화의 주역이다. 개별 시스템의 역량을 뛰어넘는 빠른 속도로 대규모 계산이 필요한 복잡한 문제를 처리한다. AI 모델의 학습과 추론 등 성능 향상과 직결된다.

HBM 연평균 60% 성장, D램 전체의 3배

2022년 말부터 이어진 챗GPT 등 생성형 AI 열풍에 AI 반도체 수요가 급증하면서 필수재인 HBM은 대호황을 누리고 있다. 시장 조사 업체 트렌드포스에 따르면 글로벌 HBM 시장은 올해 39억 달러(약

5조2000억원) 규모에서 2027년 89억 달러(약 11조8400억원) 규모로 급성장할 전망이다. 김우현 SK하이닉스 최고재무책임자(CFO)는 “HBM 수요가 중·장기적으로 연평균 60% 늘어날 것”이라며 “AI 상용화 흐름이 빨라지고 신규 사용처가 늘면서 수요가 더 가파르게 증가할 것”이라고 말했다. D램 전체 매출 증가율은 2027년까지 연평균 21%를 기록할 것으로 예상된다. HBM 시장은 이보다 3배 빠른 성장이 예상된다는 얘기다. 전체 D램 시장에서 HBM이 갖는 비중도 올해 9%에서 내년 19%로 높아질 전망이다(옴디아 전망치).

그래픽=남미가 기자 nam.miga@joongang.co.kr

한국 기업들은 그간 메모리 반도체에서 쌓은 세계 최상위의 기술력을 기반으로 이 같은 HBM 시장을 선점, 2022년 하반기부터 이어진 글로벌 반도체 업황 혹한기에 맞서고 있다. 트렌드포스에 따르면 지난해 기준 SK하이닉스가 53%, 삼성전자가 38%의 점유율로 한국이 글로벌 HBM 시장을 총 91% 점유한 상태다. 3위인 미국의 마이크론(9%)과 격차가 크다. SK하이닉스는 글로벌 AI 반도체 시장의 70%를 점유한 최강자, 미국의 엔비디아에 HBM3를 사실상 독점 공급 중이다. SK하이닉스는 2013년부터 미국 AMD와 공동으로 HBM 개발을 시작해 10여 년간 생산 노하우를 축적했다.

SK하이닉스는 이에 힘입어 지난해 4분기 HBM 매출이 사상 처음 1조원을 넘어선 것으로 관련 업계는 추정하고 있다. 고부가가치 제품인 만큼 수익성도 다른 제품보다 뛰어나다는 전언이다. HBM3와 이보다 진화한 5세대 제품인 HBM3E의 올해 주문 물량도 이미 완판된 가운데, SK하이닉스는 상반기 안에 차세대 HBM 양산에 들어가면서 HBM 1위를 굳힌다는 목표다. 김규현 SK하이닉스 D램 마케팅 담당은 “HBM3E는 상반기 중 공급이 예상된다”며 “다양한 HBM 제품으로 고객 요구에 대응하고 AI 시장에서 큰 비중을 차지할 잠재 고객으로까지 사업 영역을 확장할 계획”이라고 말했다.

“공급처 다각화, 삼성에 더 기회” 분석도

이에 맞선 삼성전자는 공격적인 투자로 HBM 1위 자리를 넘본다는 계획이다. 한진만 삼성전자 DS부문 미주총괄 부사장은 이달 초 기자들과 만나 “올해 HBM의 시설 투자를 2.5배 이상 늘리려 한다”고 밝혔다. 키움증권은 삼성전자의 지난해 4분기 HBM 최대 생산량이 월 15만~17만 장으로 SK하이닉스(월 12만~14만 장)를 넘어선 것으로 추정하고 있다. 삼성전자 입장에서 또 하나 호재는 글로벌 AI 반도체 시장에서 엔비디아의 가격 인상과 공급 조절 횡포가 지속, 마이크로소프트(MS)·아마존·메타 등의 빅테크가 자체 AI 반도체 개발에 힘쓰고 있다는 점이다. HBM을 공급할 신규 사용처가 그만큼 늘고 있다는 얘기다.

MS는 엔비디아의 경쟁사인 AMD와 협력하고 20억 달러(약 2조6600억원)를 투입해 자체 개발한 AI 반도체 ‘아테나’를 지난해 11월 공개한 바 있다. 아마존웹서비스와 메타도 자체 AI 반도체 개발 소식을 전했다. 업계 관계자는 “한국 기업이 엔비디아에 한정됐던 기존 공급처를 다각화하면서 시장 확장을 기대할 수 있을 것”이라며 “공급 대비 수요가 많을수록 가격 협상에서도 우위를 점할 수 있다”고 분석했다. SK하이닉스와 엔비디아 간의 확고한 파트너십을 고려하면 삼성전자에 조금 더 기회라는 분석도 나온다.

문제는 두 한국 기업의 경쟁 상대가 서로뿐만이 아니라는 점이다. 권석준 성균관대 화학공학·고분자공학부 교수는 “3위 마이크론이 엔비디아의 세컨드 벤더(제2의 공급사) 자리를 차지해 한국 기업을 위협할 수 있다”고 지적했다. 권 교수는 “미국 기업인 엔비디아가 역시 미국 기업인 마이크론과 거래하면 미국 정부로부터 직·간접적 지원을 받을 수 있기 때문”이라며 “품질만 뒷받침된다면 엔비디아 입장에선 마이크론 제품을 쓰는 편이 낫다고 판단할 수 있다”고 덧붙였다.

마이크론은 HBM 수요 증가에 부응하기 위해 대만과 일본의 생산 시설에 대한 투자를 대폭 강화 중이다. 김동원 KB증권 연구원은 “마이크론은 지난해 HBM3 생산을 하지 않고 올해 HBM3E 생산으로의 직행을 선언했다”며 “수율 등 양산 경쟁력 확보까지는 시간이 필요하겠지만 한국으로선 주의가 필요하다”고 말했다.

‘차세대 인터페이스’ CXL, ‘차세대 AI 반도체’ PIM도 급부상

반도체 기업들이 인공지능(AI) 시대에 새 먹거리로 낙점한 제품은 HBM뿐만이 아니다. 최근 주목 중인 신기술로 CXL(컴퓨트 익스프레스 링크)이 있다. CXL은 고성능 서버 시스템에서 중앙처리장치(CPU)와 함께 사용되는 D램과 가속기 등을 더 효율적으로 활용하기 위한 차세대 인터페이스다. 서버 구조를 바꾸지 않고 컴퓨트 인터페이스를 하나로 통합, 우수한 확장성으로 데이터 처리 속도를 높이는 기술이다. HBM보다 저렴한 가격에 메모리 용량을 늘릴 수 있다는 장점도 있다. SK하이닉스 관계자는 “CPU마다 확장할 수 있는 D램 숫자는 제한적이고, 확장한다고 해도 대규모 데이터를 처리하는 데는 애로점이 많다”며 “CXL을 쓰면 모듈을 추가하는 방식으로 메모리 용량과 대역폭을 크게 늘릴 수 있고 여러 장치에 CXL 메모리를 효율적으로 나눠 쓸 수도 있다”고 설명했다.

이를 통해 기존 시스템의 변형 없이 고성능의 공유·연산 기능으로 AI 데이터를 처리하는 단계별 환경을 잘 구축할 수 있다는 설명이다. 삼성전자 관계자는 “CXL D램은 메인 D램과 공존하면서 대역폭과 용량을 확장, AI 등 고속의 데이터 처리가 중요한 요즘 주목받고 있다”고 전했다. 세계 최초로 CXL 기반 D램 기술을 개발한 삼성전자는 지난해 128GB(기가바이트) CXL D램 개발에도 성공했다. SK하이닉스도 128GB CXL 메모리 솔루션 제품을 올해 하반기 상용화할 계획이다.

기업들은 PIM(프로세싱 인 메모리)에도 주목하고 있다. PIM은 하나의 칩 안에 메모리와 프로세서 연산기를 집적한 차세대 AI 반도체다. 메모리 내에서 자체적으로 데이터 연산 기능을 처리할 수 있다. 이를 통해 메모리와 프로세서가 분리된 기존의 컴퓨팅 구조에서 발생하는 데이터 병목 현상과 과다한 전력 소모 문제를 해결한다. 반도체 업계 관계자는 “기존 대비 전력 소모량을 30배 이상 절감할 수 있는 신기술”이라고 말했다. 삼성전자는 이를 HBM에 접목한 HBM-PIM 기술을 이달 초 세계 최대 정보기술·가전 전시회 ‘CES 2024’에 선보였다.

![[오늘의 운세] 4월 28일](https://pds.joongang.co.kr/news/component/joongang_sunday/202404/27/9866f29c-fc4e-4fd9-ad4a-3d0a95d53514.jpg.thumb.jpg/_ir_432x244_/aa.jpg)

![[초고령화 시대 노인 일자리] 대기업 상무 출신, 전문기술 배우려 또 대학에…"몸 낮추고 몸값 올리는 노력은 계속해야"](https://pds.joongang.co.kr/news/component/joongang_sunday/202404/27/ac8138be-929f-4f41-8283-4cdfa711b01f.jpg.thumb.jpg/_ir_432x244_/aa.jpg)