문장을 읽고 의미를 간파할 줄 안다는 뜻의 문해력(literacy)처럼, 그래프를 보고 정보를 꿰뚫는 능력치를 도해력(graphicacy)이라고 한다(Balchin, 1972). 데이터 시각화 분야 전문가인 알베르토 카이로의 저서 『숫자는 거짓말을 한다』에 따르면, 이러한 도해력을 키우기 위해 우선 데이터의 출처를 잘 봐야 하고, 시각화에 눈속임은 없는지 살펴야 한다. 그래프를 만드는 사람들이 꼭 악의를 띠고 있어서가 아니다. 간혹 그 쓰임새가, 누군가의 자기합리화 도구로 활용되는 사례가 종종 있어서다.

'유재연의 인사이드 트랜D'

책에서는 구체적인 사례를 200페이지 넘게 소개하고 있다. 가령 미국 트럼프 대통령이 상당히 좋아한 것으로 알려진 ‘2016년 득표 시각화 지도’가 대표적인 사례다(〈그림1〉). 트럼프는 이 지도의 빨간색을 ‘자신에 대한 국민의 지지’로 해석했지만, 사실 이 붉은 면적은 인구수가 전혀 반영되지 않은 ‘마을별 표심’에 불과했다. 실제로 다수의 인구가 살고 있는 곳은 파란색으로 표시된 도시들이었고, 개인의 득표는 당시 상대 후보이던 힐러리 클린턴이 더 많았다고 저자는 물론 CNN 팩트체크 팀에서도 밝혀냈다. 즉, 국민 한 사람 한 사람의 민심을 반영한 시각화라고 보기에는 무리가 있다는 것이다.

2016년 당시 대선 이후 소개 됐던 지도 시각화 중 하나. 로이터에 따르면, 트럼프 대통령은 이 지도를 취임 100일 인터뷰 당시 기자들에게 한 장씩 쥐어 줬다고 한다. 트럼프가 지난해년 10월에 올린 트위터 캡처.

사람은 착각을 할 수도 있다. 혹은, 보고 싶은 대로 볼 수도 있다. 그런데 이러한 현상은 갈수록 심화하고 있다. 포털사이트와 SNS에 내재한 추천 알고리즘은 자기 편향을 일으킬 수 있는 콘텐츠를 더 중점적으로 뽑아 보여 준다. 이런 이유로 가짜뉴스를 가려내려는 노력은 곳곳에서 이뤄지고 있다. 페이스북과 트위터는 이번 미 대선 기간 사실확인이 제대로 되지 않은 정치적 선동 글을 블라인드 처리하며 비교적 적극적으로 대처했다. 언론도 ‘팩트 체크’를 코너로 내걸고 가짜를 열심히 걸러내고 있다.

가짜를 걸러내는 것은 사실 AI가 꽤 잘하는 일

이상한 움직임이나 수상한 모양새를 잡아내는 것은 기계가 꽤 잘할 수 있다. 알고리즘 분야에서는 이상 탐지(anomaly detection)라는 분야가 특히 관심을 받아왔다. 묘한 계좌 이체 내역을 찾아내 탈세 시도를 포착하거나, 갑작스러운 해외 결제 발생을 탐지해 위조 신용카드 사용을 긴급히 알리는 것이 대표적 사례다. 슬쩍 다른 모양새를 찾아내는 것도 기계가 잘하는 일이다. 가령 드라마 〈스타트업〉에 나온 바와 같이, 감쪽같이 위조된 필체를 기계적으로 찾아내는 것은 이미 상당한 수준에 올라와 있다.

인공지능이 생성한 필체를 가짜인지 알아맞히는 프로그램이다. 결국에는 탐지에 성공한다. 지난달 31일에 방영된 tvN 드라마 〈스타트업〉 5화 장면.

심지어 AI가 만들어 낸 ‘가짜’를 찾아내는 것도 AI가 잘할 수 있다. 드라마에서는 위조된 필체 감지 AI가 가짜 글씨를 만들어내는 AI와 대결하는 태스크가 소개된 바 있다(〈그림2〉). 이렇게 기계가 만들어낸 이미지나 문장을 ‘딥페이크(DeepFake)’라고 하는데, 구석구석이 어쩐지 어색했던 예전과는 달리, 요즘은 어찌나 비슷한지 사람 눈으로는 구별이 잘 안 될 정도다.

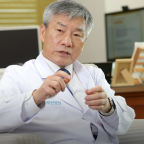

페이스북을 비롯한 여러 기업과 단체에서는 이러한 딥페이크를 찾아내는 챌린지를 지속적으로 진행하고 있다. 최근 관심을 끈 시도 중 하나는, 최근 미국 빙햄튼 대학과 인텔 연구진이 함께한 연구다. 기계가 만들어낸 가짜 얼굴을 실존하는 얼굴 이미지로부터 구별해내는 알고리즘을 개발했다(Ciftci et al., 2020). 기계는 만들어내지 못하는 사람의 피부 속 혈류를 측정해, 그 사진 속 얼굴이 기계가 만든 이미지인지 아닌지를 판별해내는 것이다(〈그림3〉).

페이크캐쳐(FakeCatcher) 알고리즘이 중점적으로 살펴본 얼굴 내 혈류 부분. Ciftci et al. 논문.

사람이 의도적으로 비튼 그래프도 찾아낼 수 있을까?

다만 기계가 만든 사진이나 이상 거래내역에서처럼, 은근히 본질을 왜곡하는 차트에 ‘가짜’라고 레이블을 다는 것은 생각보다 쉽지 않다. 레이블을 다는 사람들 모두가 도해력을 완벽하게 갖춘 지극히 중립적인 이들이어야 하는데, 일단 이 부분부터 장벽이 높다. 여기에 더해 그 차트가 어쩐지 이상하다고 꼬집어 내기 위한 인간의 능력을 기계에 쏟아붓는 방식 또한 꽤 복잡할 것으로 보인다. 그나마, 날것 그대로의 데이터를 일일이 입수해 거칠게 그래프를 그려낸 뒤, 이를 인간이 만든 차트와 비교하게 하는 정도가 현재로썬 가장 가까운 해결법 중 하나일 것이다.

차트 그 자체를 꼬집기에 앞서, 어떤 데이터가 선택됐는지에 대한 판단들도 중요하다. 책에 나온 사례처럼, 니콜라스 케이지의 영화 출연 횟수와 수영장 익사자의 수 데이터를 가져다가 그래프를 그리면 “니콜라스 케이지가 영화에 나왔다 하면 수영장에 빠져 죽는 사람이 늘어난다”는 식의 묘한 음모론이 형성되기 때문이다. 이러한 판단의 영역을 기계에게 어떻게 학습시킬 수 있을지도 관건이다.

희망적인 구석이 있다면, 현재 문맥을 읽을 줄 아는 알고리즘 연구가 자연어처리는 물론 컴퓨터 비전에서도 활발하게 진행되고 있다는 점이다. 투명한 데이터 공개를 전제로, 어느 구석에 편향이 들어갔는지를 문맥적으로 따져 잡아내는 알고리즘을 기대해 본다. 이는 궁극적으로 사람에게 판단의 옵션도 더 열어줄 것이다. 무엇보다 중요한 것은 결국, 알고리즘이 정직하게 판단해 낸 차트를 보고 사람 스스로 얼마나 치우치지 않게 논의를 이어갈 수 있느냐에 있다. 툭하면 무리로 나뉘는 세상에서는, 중심을 잡는 것이 사실 가장 어렵기 때문이다.

유재연 객원기자는 중앙일보와 JTBC 기자로 일했고, 이후 서울대 융합과학기술대학원에서 박사과정을 수료했다. 이미지 빅데이터분석, 로봇저널리즘, 감성 컴퓨팅을 활용한 미디어 분석에 관심이 많다. 현재 서울대 융합과학기술대학원 연구원으로 활동하고 있다. you.jae@snu.ac.kr

![[오늘의 운세] 4월 18일](https://pds.joongang.co.kr/news/component/htmlphoto_mmdata/202404/18/9866f29c-fc4e-4fd9-ad4a-3d0a95d53514.jpg.thumb.jpg/_ir_432x244_/aa.jpg)